pytorch中为什么要用 zero_grad() 将梯度清零

调用backward()函数之前都要将梯度清零,因为如果梯度不清零,pytorch中会将上次计算的梯度和本次计算的梯度累加。

这样逻辑的好处是,当我们的硬件限制不能使用更大的bachsize时,使用多次计算较小的bachsize的梯度平均值来代替,更方便,坏处当然是每次都要清零梯度。

optimizer.zero_grad()

output = net(input)

loss = loss_f(output, target)

loss.backward()

补充:Pytorch 为什么每一轮batch需要设置optimizer.zero_grad

CSDN上有人写过原因,但是其实写得繁琐了。

根据pytorch中的backward()函数的计算,当网络参量进行反馈时,梯度是被积累的而不是被替换掉;但是在每一个batch时毫无疑问并不需要将两个batch的梯度混合起来累积,因此这里就需要每个batch设置一遍zero_grad 了。

其实这里还可以补充的一点是,如果不是每一个batch就清除掉原有的梯度,而是比如说两个batch再清除掉梯度,这是一种变相提高batch_size的方法,对于计算机硬件不行,但是batch_size可能需要设高的领域比较适合,比如目标检测模型的训练。

关于这一点可以参考这里

关于backward()的计算可以参考这里

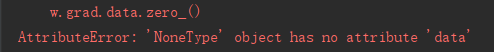

补充:pytorch 踩坑笔记之w.grad.data.zero_()

在使用pytorch实现多项线性回归中,在grad更新时,每一次运算后都需要将上一次的梯度记录清空,运用如下方法:

w.grad.data.zero_()

b.grad.data.zero_()

但是,运行程序就会报如下错误:

报错,grad没有data这个属性,

原因是,在系统将w的grad值初始化为none,第一次求梯度计算是在none值上进行报错,自然会没有data属性

修改方法:添加一个判断语句,从第二次循环开始执行求导运算

for i in range(100):

y_pred = multi_linear(x_train)

loss = getloss(y_pred,y_train)

if i != 0:

w.grad.data.zero_()

b.grad.data.zero_()

loss.backward()

w.data = w.data - 0.001 * w.grad.data

b.data = b.data - 0.001 * b.grad.data

以上为个人经验,希望能给大家一个参考,也希望大家多多支持脚本之家。

您可能感兴趣的文章:- PyTorch梯度裁剪避免训练loss nan的操作

- Pytorch训练过程出现nan的解决方式

- pytorch 权重weight 与 梯度grad 可视化操作

- PyTorch 如何检查模型梯度是否可导

- PyTorch 如何自动计算梯度

- pytorch 梯度NAN异常值的解决方案

咨 询 客 服

咨 询 客 服