| hostname | ip | 系统版本 |

|---|---|---|

| cdh1 | 10.30.10.111 | centos7 |

| cdh2 | 10.30.10.112 | centos7 |

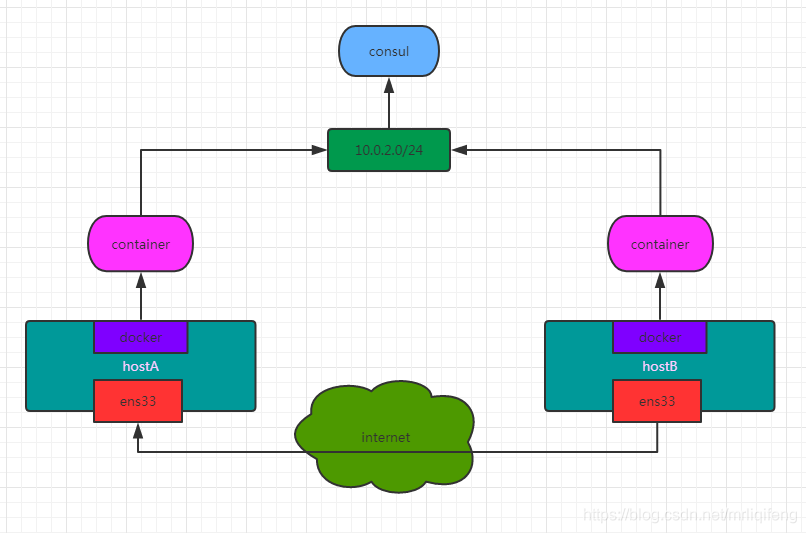

要实现overlay网络,我们会有一个服务发现。比如说consul,会定义一个ip地址池,比如10.0.2.0/24之类的。上面会有容器,容器的ip地址会从上面去获取。获取完了后,会通过ens33来进行通信,这样就可以实现跨主机的通信。

consul通过docker部署在cdh1,首先需要修改cdh1中的docker配置并重启

[root@cdh1 /]# vim /etc/docker/daemon.json //添加以下配置 "live-restore":true [root@cdh1 /]# systemctl restart docker

“live-restore”:true 此配置的作用为在docker守护程序停止或重启的时候,容器依然可以保持运行

在cdh1下载consul镜像并启动

[root@cdh1 /]# docker pull consul [root@cdh1 /]# docker run -d -p 8500:8500 -h consul --name consul consul

修改cdh1中的docker配置并重启

[root@cdh1 /]# vim /etc/docker/daemon.json # 添加以下两行配置 "cluster-store": "consul://10.30.10.111:8500" "cluster-advertise": "10.30.10.111:2375" [root@cdh1 /]# systemctl restart docker

修改cdh2中的docker配置并重启

[root@cdh2 /]# vim /etc/docker/daemon.json # 添加以下两行配置 "cluster-store": "consul://10.30.10.111:8500" "cluster-advertise": "10.30.10.112:2375" [root@cdh2 /]# systemctl restart docker

cluster-store指定的是consul服务地址,因为consul服务运行在cdh1的8500端口,所以两台机器的cluster-store值均为consul://10.30.10.111:8500

cluster-advertise指定本机与consul的通信端口,所以指定为本机的2375端口

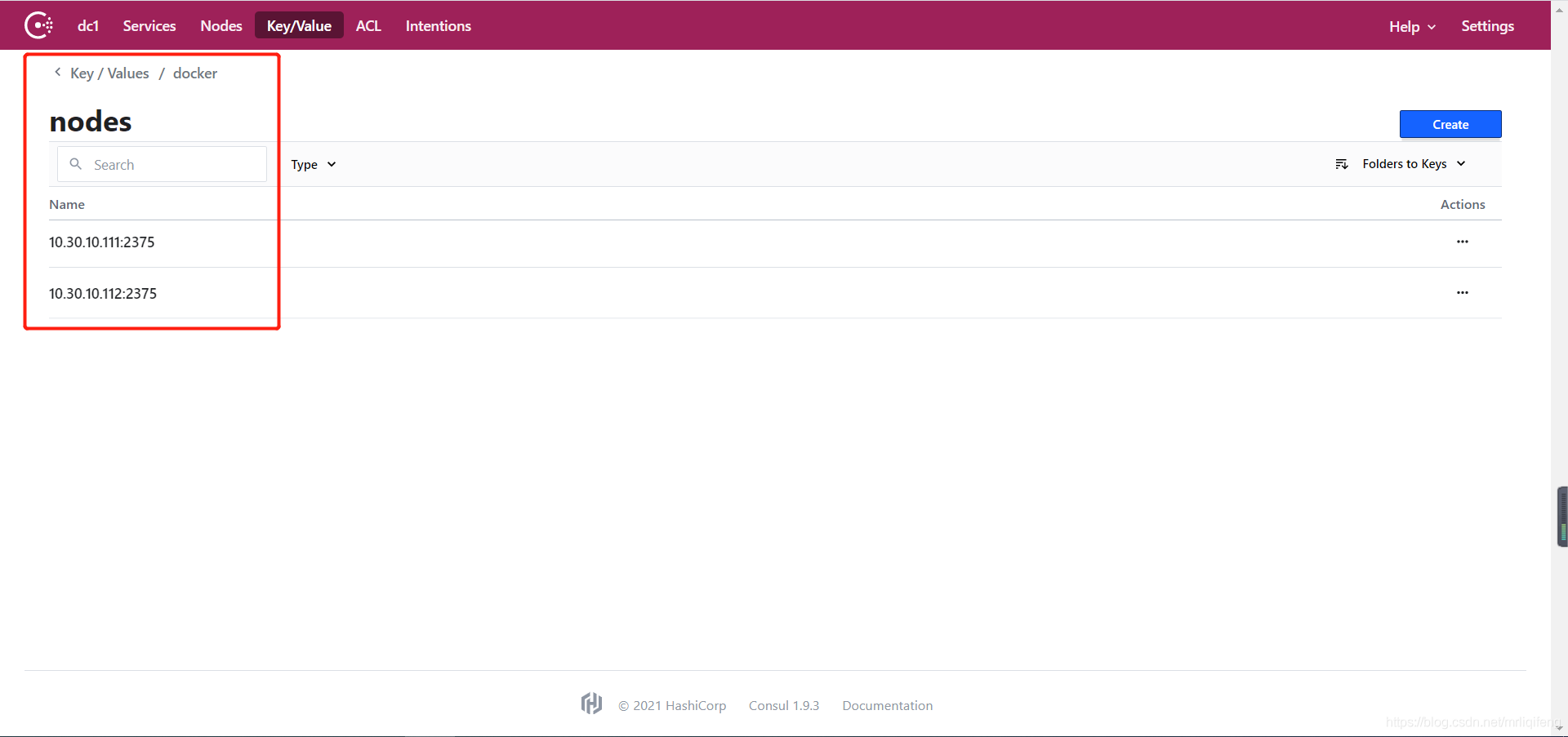

此时可以通过http://10.30.10.111:8500/访问consul地址

在Key/Value菜单中的docker-nodes目录中可以看到cdh1和cdh2两个docker节点,代表consul配置成功。

此时我们可以创建overlay网络,首先查看目前节点中已有的网络类型

[root@cdh1 /]# docker network ls NETWORK ID NAME DRIVER SCOPE ab0f335423a1 bridge bridge local b12e70a8c4e3 host host local 0dd357f3ecae none null local

然后在cdh1的docker节点创建overlay网络,因为此时consul服务发现已经正常运行,且cdh1和cdh2的docker服务已经接入,所以此时overlay网络是全局创建的,在任何一台宿主机创建一次即可。

[root@cdh1 /]# docker network create -d overlay my_overlay cafa97c5cf9d30dd6cef08a5e9710074c828cea3fdd72edb45315fb4b1bfd84c [root@cdh1 /]# docker network ls NETWORK ID NAME DRIVER SCOPE ab0f335423a1 bridge bridge local b12e70a8c4e3 host host local cafa97c5cf9d my_overlay overlay global 0dd357f3ecae none null local

此时可以看到,创建的overlay网络,标识为golbal。我们可以查看cdh2的网络,可以发现overlay网络也已经创建完毕。

[root@cdh2 ~]# docker network ls NETWORK ID NAME DRIVER SCOPE 90d99658ee8f bridge bridge local 19f844200737 host host local cafa97c5cf9d my_overlay overlay global 3986fe51b271 none null local

创建完成后,我们可以在cdh1和cdh2中指定overlay网络创建docker容器,并进行测试,查看是否可以跨宿主机通信。

在cdh1中创建名称为master的容器,并查看其IP

[root@cdh1 /]# docker run -itd -h master --name master --network my_overlay centos7_update /bin/bash

[root@cdh1 /]# docker inspect -f "{{ .NetworkSettings.Networks.my_overlay.IPAddress}}" master

10.0.0.2

在cdh1中创建名称为slaver的容器,并查看其IP

[root@cdh2 ~]# docker run -itd -h slaver --name slaver --network my_overlay centos7_update /bin/bash

[root@cdh2 ~]# docker inspect -f "{{ .NetworkSettings.Networks.my_overlay.IPAddress}}" slaver

10.0.0.3

此时进入两台容器中,互相ping对方的IP,查看是否成功通信

[root@cdh1 ~]# docker exec -it master /bin/bash [root@master /]# ping 10.0.0.3 PING 10.0.0.3 (10.0.0.3) 56(84) bytes of data. 64 bytes from 10.0.0.3: icmp_seq=1 ttl=64 time=0.587 ms 64 bytes from 10.0.0.3: icmp_seq=2 ttl=64 time=0.511 ms 64 bytes from 10.0.0.3: icmp_seq=3 ttl=64 time=0.431 ms 64 bytes from 10.0.0.3: icmp_seq=4 ttl=64 time=0.551 ms 64 bytes from 10.0.0.3: icmp_seq=5 ttl=64 time=0.424 ms ^C --- 10.0.0.3 ping statistics --- 5 packets transmitted, 5 received, 0% packet loss, time 4000ms rtt min/avg/max/mdev = 0.424/0.500/0.587/0.070 ms

[root@cdh2 ~]# docker exec -it slaver /bin/bash [root@slaver /]# ping 10.0.0.2 PING 10.0.0.2 (10.0.0.2) 56(84) bytes of data. 64 bytes from 10.0.0.2: icmp_seq=1 ttl=64 time=0.499 ms 64 bytes from 10.0.0.2: icmp_seq=2 ttl=64 time=0.500 ms 64 bytes from 10.0.0.2: icmp_seq=3 ttl=64 time=0.410 ms 64 bytes from 10.0.0.2: icmp_seq=4 ttl=64 time=0.370 ms ^C --- 10.0.0.2 ping statistics --- 4 packets transmitted, 4 received, 0% packet loss, time 3000ms rtt min/avg/max/mdev = 0.370/0.444/0.500/0.062 ms

成功通信!

到此这篇关于docker容器间跨宿主机通信-基于overlay的实现方法的文章就介绍到这了,更多相关docker容器间跨宿主机通信内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!

咨 询 客 服

咨 询 客 服