| 表达式 | 描述 |

|---|---|

| / | 从根节点选取(取子节点) |

| // | 选择的当前节点选择文档中的节点 |

| . | 选取当前节点。 |

| … | 选取当前节点的父节点。 |

| @ | 选取属性 |

| * | 表示任意内容(通配符) |

| | | 运算符可以选取多个路径 |

常用功能函数

| 函数 | 用法 | 解释 |

|---|---|---|

| startswith() | xpath(‘//div[starts-with(@id,”ma”)]‘) | #选取id值以ma开头的div节点 |

| contains() | xpath(‘//div[contains(@id,”ma”)]‘) | #选取id值包含ma的div节点 |

| and() | xpath(‘//div[contains(@id,”ma”) and contains(@id,”in”)]‘) | #选取id值包含ma的div节点 |

| text() | _.xpath('./div/div[4]/a/em/text()') | #选取em标签下文本内容 |

备注:

1、html中当相同层次存在多个标签例如div,它们的顺序是从1开始,不是0

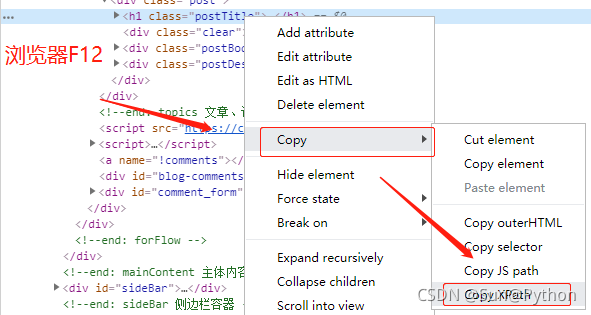

2、浏览器中使用开发者工具可以快速获取节点信息

#!/usr/bin/python3

# -*- coding: utf-8 -*-

# @Time : 2021/9/7 9:35

# @Author : Sun

# @Email : 8009@163.com

# @File : sun_test.py

# @Software: PyCharm

import requests

from lxml import etree

def get_web_content():

try:

url = "htpps://***keyword=%E6%97%A0%E9%92%A2%E5%9C%88wq=%E6%97%A0%E"

"9%92%A2%E5%9C%88ev=1_68131%5Epvid=afbf41410b164c1b91d"

"abdf18ae8ab5cpage=5s=116click=0 "

header = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; WOW64)"

"AppleWebKit/537.36 (KHTML, like Gecko) "

"Chrome/75.0.3770.100 Safari/537.36 "}

response = requests.request(method="Get", url=url, headers=header)

result = response.text

return result

except TimeoutError as e:

return None

def parsing():

result = get_web_content()

if result is not None:

html = etree.HTML(result)

# 先获取一个大的节点,包含了想要获取的所有信息

ii = html.xpath('//*[@id="J_goodsList"]/ul/li')

for _ in ii:

# 采用循环,依次从大节点中获取小的节点内容

# ''.join() 将列表中的内容拼接成一个字符串

infoResult = {

# @href 表示:获取属性为href的内容

'href': "https:" + _.xpath('./div/div[1]/a/@href')[0],

'title': ''.join(

_.xpath('./div/div[2]/div/ul/li/a/@title')),

# text()表示获取节点i里面的文本信息

'price': _.xpath('./div/div[3]/strong/i/text()')[0],

'info': ''.join(

_.xpath('./div/div[4]/a/em/text()')).strip(),

'province': _.xpath('./div/div[9]/@data-province')[0]}

print(infoResult)

else:

raise Exception("Failed to get page information, please check!")

return None

if __name__ == '__main__':

parsing()

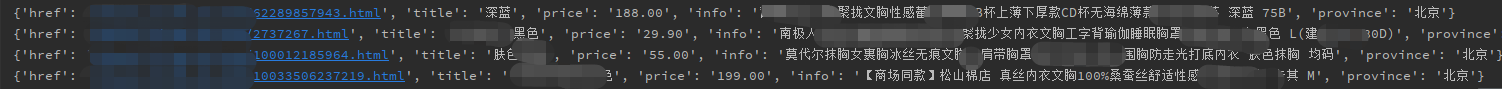

结果图片:

到此这篇关于python使用xpath获取页面元素的使用的文章就介绍到这了,更多相关python xpath获取页面元素内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!

咨 询 客 服

咨 询 客 服