文/脑极体

比来,很多企业都在谈算法的价值不雅观。在乌镇互联网大会上,张朝阳谈到了这个话题,在之前今日头条举办的AI大会上,哈佛教授Cyrus Hodes也提到人工智能应该承担更多的社会责任。

在以前看到这种论调,我总想为企业喊冤。技术钻研、产品开发、组织经营已经很费力了,企业创造价值、提供就业就已经足够负责了。还要为算法技术这种来源于用户数据的东西塑造价值不雅观?不过在了解过Facebook一个有颇多争议的实验后,我开始逐渐改变了这种想法。

在 2013 年,Facebook联合康奈尔大学、UC旧金山分校的研究员在 2013 年于美国国家科学院院刊颁发了一篇名为“社交网络中大规模情绪扩散的实验证据”的论文。

实验的主要内容是,更改用户信息流中的情绪,看看用户会有怎样的反馈。事实证明,在用户信息流中灌输“正能量”的信息,用户也会给出正面的反馈,反之则是给出负面的反馈。

由于这则实验是在用户不知情的情况下进行的,“实验”人数涉及到了将近七十万人。互联网上对这则实验进行了强烈的报复,认为Facebook的行为极大的违反了人伦道德。

其实我们都知道,真正让人们感到恐惧的,是Facebook可以通过信息流轻易把持人们情绪这件事。

从猎手到猎物,弱者才会被“把持”

回溯到互联网的“上古时代”,人们寻找信息的方式是非常简单的。例如搜狐的黄页形式,整个互联网上的信息百里挑一,以至于可以用分类摆列的形式展现出来。当时的人们要知道本身要找的网站属于那一类,才能在黄页互联网上尽情冲浪。

此时人们对获取信息的把控力可以达到90%。在昂贵的拨号网络之外,还有大量的电视、广播、纸质媒体构成人们对世界的认知。

随着信息的发作式增长,一本黄页已经远远不足够。到了谷歌、百度的搜索引擎时代,关键词成为了寻找信息的利器。这时的人们已经可以带着问题来寻找信息,SEO、SEM等等广告形式也让企业开始有权力去“控制”用户看到那些信息。

同时,廉价的宽带资费和更丰富的信息增加了互联网的权重,让其在人类认知来源构成中的地位更高。换句话说,人类认识世界的窗口变窄了。

比及了今天,移动终端的小屏特征带来了信息流和时间线,而这两者一个来自于编纂保举/算法保举,另一个则来自于用户的关注关系。人们已经很难再去主动寻找信息,而是接受编纂、算法认为适合他们的信息。

此时,移动互联网下沉基本完毕,人们获取信息的渠道更为集中,对于获取信息的把控程度却不才降。人们从信息的狩猎者逐渐酿成猎物,难怪会被信息流控制本身的情绪。

让渡信息窗口,直到成为算法的镜中人

其实互联网发展的过程,可以被看做一个人类不停让渡信息窗口的过程。

从黄页时期到搜索引擎的发展中,我们把部分信息窗口让渡给了流量和金钱。广告主和高热度话题有权力占据我们信息窗口的主要位置。而从发展引擎到信息流的发展中,社交关系和原生广告加大了高热度话题和广告主在信息窗口中的占比,而剩下的部分则被让渡给保举算法和编纂。

信息流的出现,是这个让渡的过程中最为关键的一步。我们虽然把信息窗口交了出去,却获得了更多、更具个性化的信息。黄页时代的几十万个网站怎么可能满足人们丰富的需求?广告主会鼓励内容创造者创造更多内容,编纂和保举算法帮手我们找到最适合我们的内容。

这一切看似是非常良性的循环,可问题的关键在于:信息流和保举算法无处不在,它们已经不但仅意味着我们浏览什么,而对我们生活的很多方面都起到了关键性的作用。

Facebook的实验,只是简单的校验了一下信息茧房的假说,结果却发现信息流可能会影响到人们的情绪。实际在购物、旅行、音乐等等的选择上,我们都会被信息流摆布。

信息流影响了我们读什么新闻、看什么电影、买什么东西,而这些行为数据又被记录下来,,成为了自身画像的一部分,也成了算法构成的依据,某种程度来说,这一切都会让我们和算法中的本身越来越像。

算法的第一要务是……

当人们和算法中的本身越来越像(即使只是有这种可能性),算法的价值不雅观、人工智能的责任感这种论调就有了存在的须要。在内心深处,我们感受到了一种对自我把控的无力感。提出价值不雅观、责任感这种要求,就好像弱者对强者耍赖,要求签订一条互不侵犯的条约。

那么问题是,难道就是为了我们本身的不安适感,信息流相关技术作为窗口的缔造者,就有须要五讲四美、三热爱?

这时问题就上升到了更高形态:成为健康美好正直的人,是一种普世的价值不雅观。可没人有权力阻止另一个人成为鄙陋阴险低俗的人。

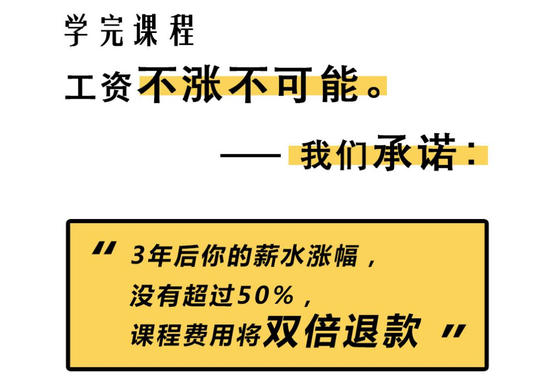

咨 询 客 服

咨 询 客 服